DialogFlow, votre chatbot facile

Il existe aujourd'hui de nombreuses aides à la mise en place des ChatBots conversationnels dits intelligents. On parlera aujourd'hui spécifiquement de DialogFlow, anciennement Api.ai de Google.

Sommaire

Jeudi 19 octobre 2017 a eu lieu à Paris au Palais des Congrès, le Google Cloud Summit 2017. Google venait à Paris pour exposer toutes les nouveautés de leur Cloud, les nouvelles API de Machine Learning et les nouveaux outils de collaboration. Bien sûr Eleven était présent et nous avons pu suivre la plupart des conférences.

#GoogleCloudSummit with @CaptainJojo42 & @Pouz0r pic.twitter.com/GYCxUddFB2

— VEBER Arnaud (@VEBERArnaud) 19 octobre 2017

@Eleven_Labs en force au #GoogleCloudSummit #paris avec @VEBERArnaud @Pouz0r @alexvndre pic.twitter.com/ifge71wj7Q

— Jonathan (@CaptainJojo42) 19 octobre 2017

Sebastien Marotte ouvre le bal, en expliquant que même si le cloud Google n'est pas le leader du marché, il devient de plus en plus fort et continue à avancer vers le futur.

Ouverture de la keynote avec Sébastien Marotte, vice-président de Google Cloud EMEA. #Googlesummit17 #cloud pic.twitter.com/73ncb4lzjd

— Sopra Steria France (@SopraSteria_fr) 19 octobre 2017

C'est d'ailleurs en s'inspirant d'un citation de Larry Page que Sébastien Marotte commence à nous exposer les bases du Cloud Google.

Merci Sébastien Marotte for hosting #googlesummit17 it's exciting to see you & SIs do 10x projects with @googlecloud pic.twitter.com/39ZU109d5q

— Gard Little (@GardLittle) 19 octobre 2017

Puis laissons place à Ulku Rowe.

Qui va nous présenter pourquoi le cloud Google est le meilleur. Elle commence par nous montrer ce que doit être le futur des sociétés.

Les clés de la réussite des sociétés #GoogleCloudSummit #paris pic.twitter.com/RiYDcjCaQZ

— Jonathan (@CaptainJojo42) 19 octobre 2017

Ulku Rowe insistera longuement sur la sécurité des services Cloud, sur leurs performances, sur la collaboration et sur les liens avec les partenaires.

C'est alors que plusieurs intervenants sont venu faire des démonstrations des outils Google. D'abord le partage, avec en tâche de fond -comme dans l'ensemble des conférences- la Data. Une démonstration sur l'utilisation de l'outil Explorer de Google Sheet. Explorer devient malin et peut créer seul des query compliquées.

Puis, on y reviendra plus tard, une présentation de la Cloud Vision API, assez impressionnantes car permettant de reconnaitre instantanément les visages.

La conférence continuera avec un chiffre effrayant.

La dure réalité. Trop de maintenance pas assez d’insights. @Eleven_Labs #GoogleSummit17 #paris pic.twitter.com/mhCpoqCVk8

— Jonathan (@CaptainJojo42) 19 octobre 2017

On passe tous beaucoup trop de temps à faire de la maintenance et non dans les insights pour nos clients. C'est pour cela que le Cloud Google est parfait, car il n' y a pas besoin de faire maintenance, Google le fait pour vous, et vous pouvez passer votre temps de travail à trouver les insights pour vos clients. Mais Google ne s'arrête pas là, l'avenir est pour eux la Data, et comment comprendre celle-ci est l'avenir. C'est pour cela que Google met en place énormément d'outils pour aider les sociétés à comprendre la données qu'ils ont à disposition.

La plénière se terminera par plusieurs exemples clients, sur comment travailler avec la Data et comment Google a aidé à l'utiliser et la comprendre.

D'abord Dailymotion

Our cousins from dailymotion spekaing datas @ #googlesummit17 pic.twitter.com/QBi3BiHYLu

— Gilles Chervy (@gilles_chervy) 19 octobre 2017

Puis La Redoute avec la blague de la Google Summit.

Introducing Google Big Kiri #googlesummit17 pic.twitter.com/l4j6IFQwh8

— Olivier LOVERDE (@loverdeolivier) 19 octobre 2017

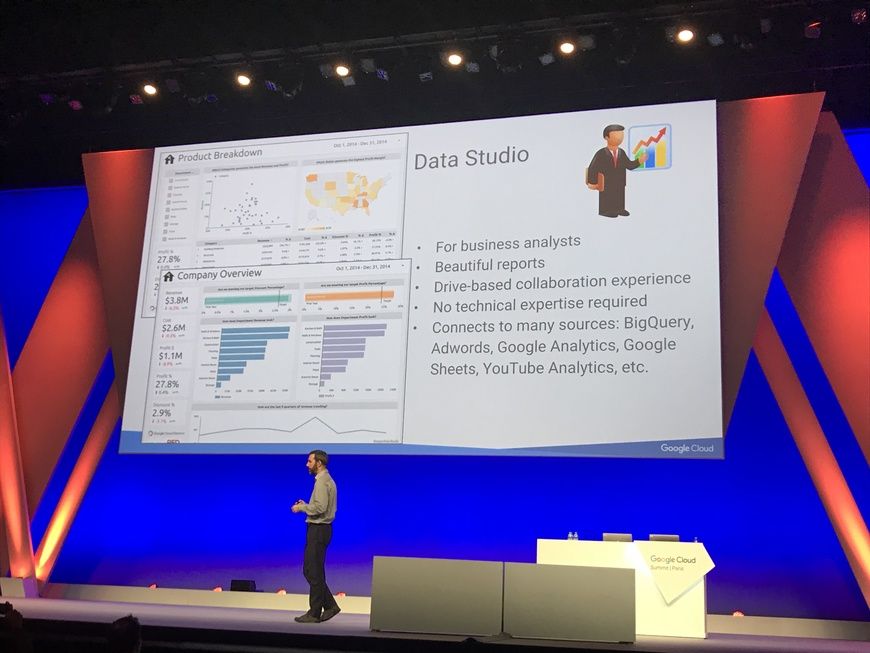

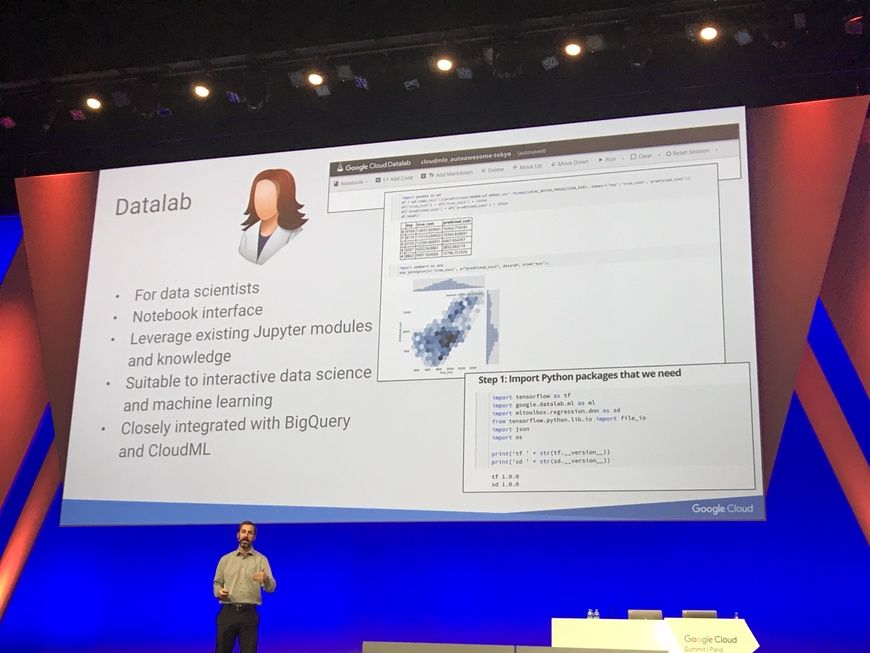

Première conférence et premiers défis : comment récupérer, stocker et comprendre l'ensemble des données. Pour commencer Google nous présente deux outils de visualisation, DataLab et DataStudio.

Datalab est un outil orienté développeur qui permet de suivre les données que vous ingérez dans votre Cloud Google.

Quantà DataStudio, il s'agit d'un outil pour l'analyse des données calculées. Il est gratuit et peut se pluguer avec de nombreuses bases de données. Il vous permet de créer des dashboards pour vos équipes marketing, analystes, etc...

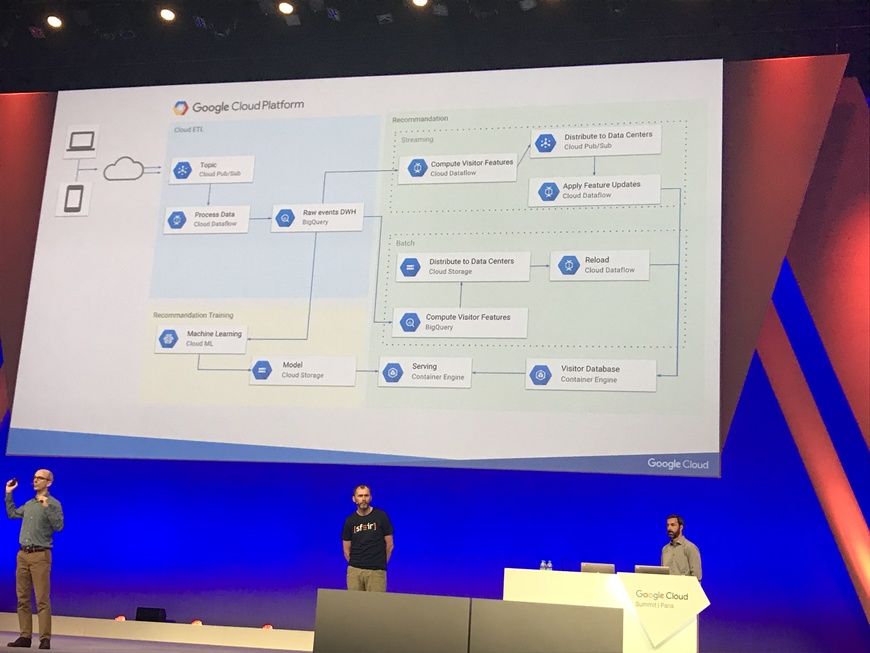

La conférence continue avec l'exemple client de Dailymotion et SFEIR qui ont travaillé ensemble pour mettre en place le système de recommandation de Dailymotion.

Ce qu'il faut retenir c'est qu'une stack compliquée il y a quelques années devient simple aujourd'hui avec Google.

Le présent et le futur de la #bigdata au #googlesummit17 #paris. @dailymotion @sfeir @Eleven_Labs pic.twitter.com/vRBqKT5XHl

— Jonathan (@CaptainJojo42) 19 octobre 2017

La suite fut les étapes de la conception du système de recommandation, tout d'abord en faisant un ETL permettant de prendre l'ensemble des données necessaires au système.

#datawarehouse etape 1 #googlesummit17 #paris @eleven_labs #pubsub #dataflow #bigquery pic.twitter.com/VEFhGxmOk3

— Jonathan (@CaptainJojo42) 19 octobre 2017

Puis de créer une architecture permettant avec du machine learning de faire ce fameux système.

Le plus de la conférence est de voir que le système qui il y a quelque années aurait été impossible, est aujourd'hui simple à mettre en place via les technologies Google. En moins de 3 mois, Dailymotion a réussi avec SFEIR à mettre en place un système de recommendation en temps réel.

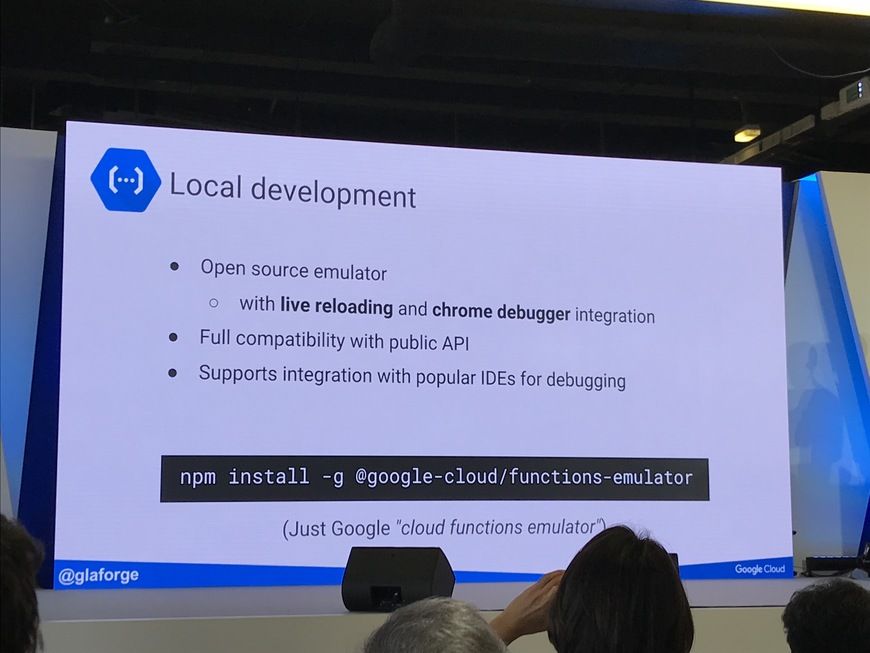

Guillaume Laforge est venu nous parler de Google Functions. Google Functions est une des technologies serverless de google.

Il commence par un petit historique desdites technologies.

@googlecloud petite frise chronologique #googlesummit17 #paris @glaforge @Eleven_Labs pic.twitter.com/HWNJH3vDBC

— Jonathan (@CaptainJojo42) 19 octobre 2017

Puis il rentre dans le concret avec des exemples. D'ailleurs toute la journée les speakers utiliseront les functions pour faire leurs démos.

Les Google Functions sont des petits codes javascript qui sont lancés lors d'un évènement, soit HTTP (un appel), soit un évènement du cloud Google, comme un ajout de fichier dans un cloud Storage.

Guillaume Laforge s'attardera sur 3 exemples :

La chose importante à retenir ici, c'est que Google a pensé à tout et a créer un emulator pour vous permettre de développer facilement.

Une conférence fascinante sur comment fonctionne le machine learning.

Google depuis plusieurs années utilise le machine learning dans l'ensemble de ses projets. Google a même utilisé le machine learning pour réduire de 40% la puissance énergétique de ses DataCenters.

Le machine learning en 3 images c'est...

#MachineLearning en 3 images #googlesummit17 @Eleven_Labs pic.twitter.com/JipEYaowx4

— Jonathan (@CaptainJojo42) 19 octobre 2017

Google a même créé ses propres Processeurs et TPU pour augmenter les performances dans les DataCenters, pour faire du machine learning.

La conférence prouve que le machine learning est essentiel pour l'avenir de nos entreprises, la question qu'il faut se poser est

Quelles données en notre possession devons-nous tagger ?

C'est là qu'il faut faire du machine learning.

La conférence se termine par l'intervention de Deeptomatic qui permet à tout le monde de faire du machine learning simplement gràce à une interface claire et simple. Avec derrière, encore une fois, la puissance du Cloud Google qui permet de réaliser des choses avec une simplicité déconcertante.

Pour moi la conférence avec le plus de code (enfin). L'idée est de montrer la puissance des APIs de Google.

Nous aurons droit à la démonstration des 5 APIs de machine learning de Google.

Api très connue de Google, elle permet de traduire des textes en de nombreuses langues.

Vous trouverez des exemples ici.

Aujourd'hui, l'API est encore plus pertinente car Google utilise du machine learning pour améliorer ses traductions.

C'est l'API utilisée dans DataDialog qui permet aujourd'hui d'avoir des Google Homes capable de comprendre ce que l'on dit.

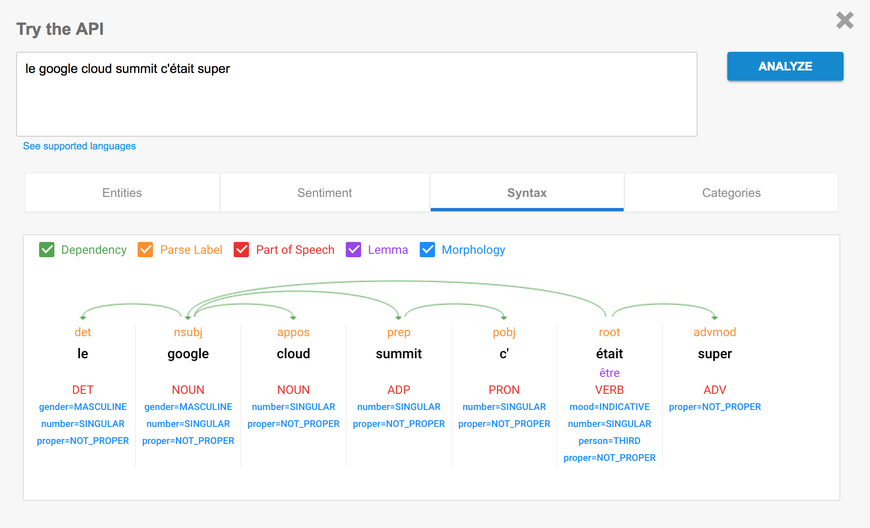

Aujourd'hui l'API permet de définir dans des phrases, l'utilité de chaque mot et de comprendre à quoi ce dernier sert. Vous pouvez aussi connaître la catégorie de la conversation, les sentiments de la phrase et de chaque mot. Et pour finir elle vous donne la syntaxe de la phrase.

Vous trouverez des exemples ici.

Comme l'API cloud natural language, elle est utilisée dans Google Home pour transformer l'audio en texte et permettre ensuite d'être analysé.

Vous trouverez des exemples ici

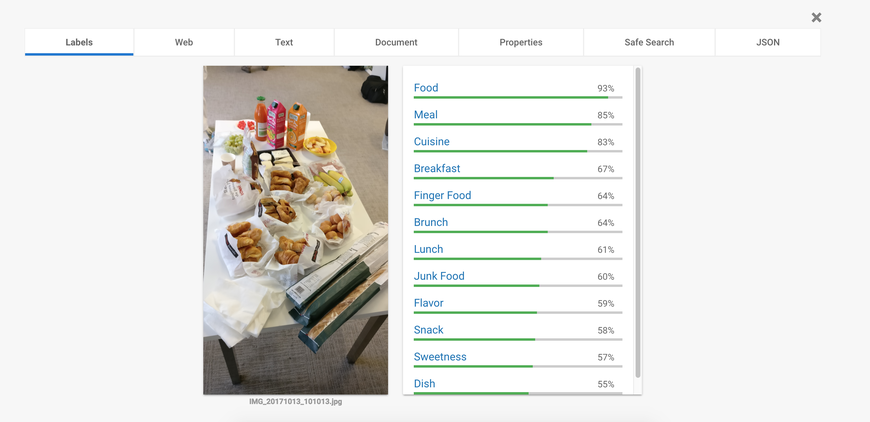

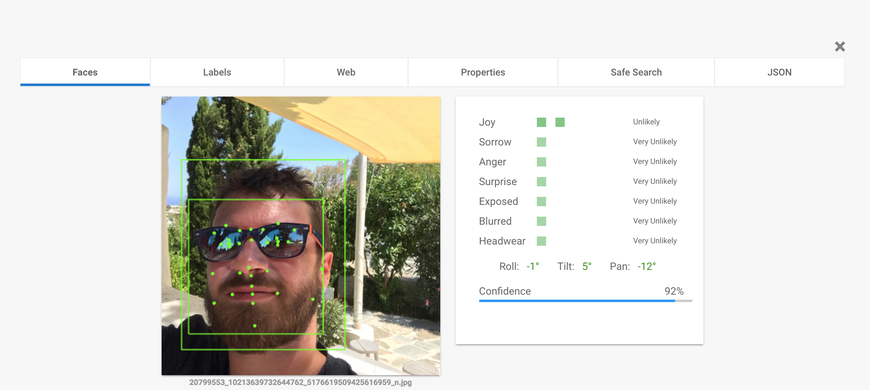

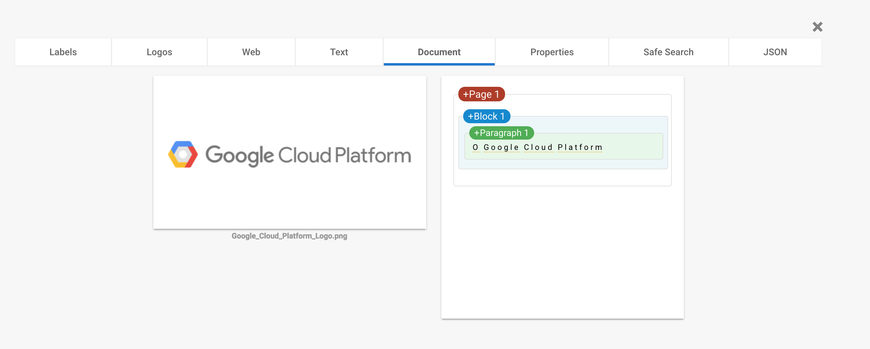

L'API permet de reconnaître ce qu'il y a sur des images. On peut l'utiliser de 3 manières différentes.

La première, c'est de tagger ce qu'il y a sur l'image :

La seconde permet de reconnaître des visages et de connaître le sentiment des personnes :

La dernière permet de reconnaître des caractères et grâce à l'API de natural language d'identifier ce qu'il se dit :

L'API est vraiment impressionnante et demande à être prise en main.

Vous pouvez vous amuser ici.

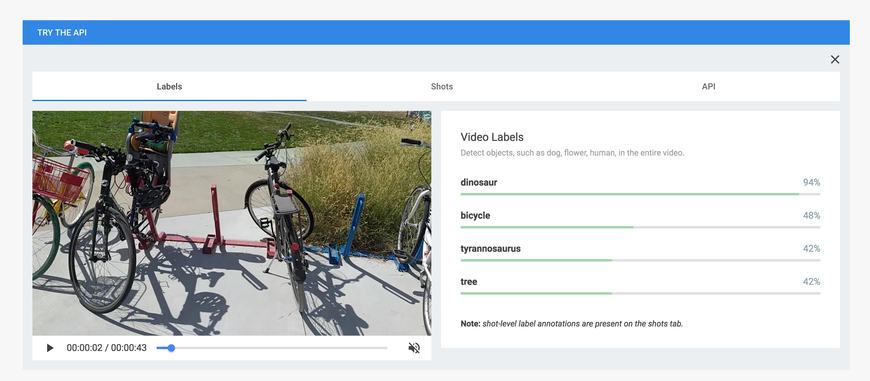

Maintenant que Google sait faire tellement de choses avec les images, il s'attaque à la video.

Cette API permet de tagger chaque partie de la video en prenant ce qui se passe dedans et même de suivre des visages dans une vidéo.

Cette API est en bêta mais vous pouvez trouvez les exemples ici.

Google prouve encore sa persistance dans l'innovation, et sa volonté d'offrir à ses utilisateurs de nombreuses fonctionnalités qui étaient hier encore perçue comme relevant de la science fiction.

Auteur(s)

Jonathan Jalouzot

Lead développeur au @lemondefr, mes technologies sont le symfony depuis 2009, le nodejs, l'angularjs, rabbitMq etc ... J'adore les médias et aimerai continuer dans ce secteur plein de surprise. Vous pouvez me retrouver sur les réseaux sociaux: Twitter: @captainjojo42 Instagram: @captainjojo42 Linkedin: https://fr.linkedin.com/in/jonathanjalouzot Github: https://github.com/captainjojo

Vous souhaitez en savoir plus sur le sujet ?

Organisons un échange !

Notre équipe d'experts répond à toutes vos questions.

Nous contacterDécouvrez nos autres contenus dans le même thème

Il existe aujourd'hui de nombreuses aides à la mise en place des ChatBots conversationnels dits intelligents. On parlera aujourd'hui spécifiquement de DialogFlow, anciennement Api.ai de Google.

L'une des étapes incontournables d'Amazon Web Service est de bien comprendre le service IAM (Identity and Access Management). C'est l'un des services les plus importants car il permet de gérer les utilisateurs ou services qui peuvent avoir accès à votre compte AWS. Nous allons l'étudier ensemble.

Depuis un an je travaille en tant qu'expert webperformance chez France Medias Monde dans le cadre de la refonte de l'ensemble des fronts des différents sites web du groupe. Nous allons revenir sur cette expérience, pour nous permettre de comprendre comment réaliser ce genre de mission.